近日歐洲國會議員以為他們正在通過Zoom與俄羅斯反對派人員視訊交談,但後來發現是長相看起來一模一樣的個騙子!首次利用深偽技術(Deepfake)來進行惡意視訊可能已經出現……

2017年 12月《神力女超人》(Wonder Woman)女主角蓋兒加朵(Gal Gadot) 的臉被移花接木到A片上,逼真度簡直毫無破綻。該段影片是以AI演算法產生,機器大量讀取蓋兒加朵(Gal Gadot)的影像後,複製出一張相似度極高的臉孔,再覆蓋A片女主角臉上。

華盛頓大學研究團隊2017年也發表一系列美國前總統歐巴馬的「造假」影片,當時該團隊僅分析17小時的歐巴馬演講影片就達到惟妙惟肖的成果。台灣總統大選期間,也有某候選人被惡搞。

現在甚至出現「換臉」軟體出,也讓深度偽造 (deepfake)惡搞影片愈來愈多。

趨勢科技在這幾年來一直在警告深偽技術(Deepfake)的技術日趨成熟。它利用AI技術製作聲音和影像來欺騙使用者相信它是真實的。

不幸的是,幾天前的事件顯示出此技術可能已經發展非常迅速,取得長足的進步。

四月底的一個例子讓我們知道此技術在短短幾年內取得了多大的進步。英國、拉脫維亞、愛沙尼亞、立陶宛和荷蘭等歐洲多國的議員,頻頻接到俄羅斯反對派領導人阿列克謝·納瓦尼(Alexei Navalny)的親密盟友兼參謀長列昂尼德·沃爾科夫(Leonid Volkov)的視訊通話。直到其中一位政治人物發出螢幕截圖指出該視訊可能是造假。(相關報導: 俄反對派遭人用Deepfake冒充)

Par viltus @leonidvolkov jeb: kā trīs Baltijas valstis satika viltvārdi un kā vēlāk tāpat “uzķērās” @ltvzinas. Mans skaidrojums šeit: https://t.co/KClylfJEiV.

— Rihards Kols (@RihardsKols) April 22, 2021

Attēlā – īstais un neīstais @leonidvolkov. Cik viegli vai grūti abi atšķirami – to vērtējiet paši. pic.twitter.com/q6IZf5kVYL

■沃爾科夫真人照片(左)與冒認者(右)看起來一模一樣。

什麼是深偽技術(Deepfake)?

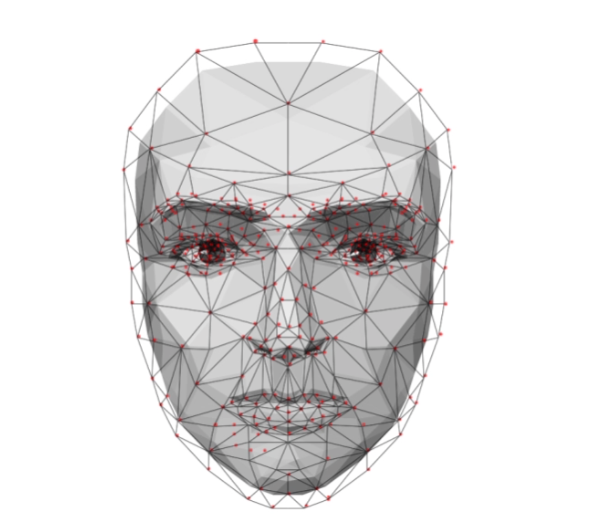

想知道什麼是深偽技術(Deepfake),只需想一想這字本身:結合了「深度學習(Deep Learning)」和「偽造媒體(Fake Media)」。製作這類內容的方式各有不同。但一般來說,被稱為「自動編碼器(autoencoder)」的深度神經網路技術經過訓練後就可以接收影像輸入、壓縮再加以重製。這樣對兩個不同臉孔的影像串流進行處理然後交換,讓人物A的面部表情和手勢模仿人物B。透過這種技術就可以讓任何人說出你要說的話。

此外,深偽技術(Deepfake)也出現了其他概念證明的運用,引發此技術在未來可能會如何演變的討論。

儘管對此次事件的準確性仍存在爭議,但它仍向我們證明了已經取得很大的進展。隨著此一現實的接近,整個網路安全產業、監管單位和政府都需要做好準備。

歐盟和美國聯邦貿易委員會等組織將繼續採取積極措施,透過新法規遏制惡意使用或濫用AI技術的可能行為。

現在是資安主管將深偽技術(Deepfake)加入其惡意威脅應對計劃的時候了,業界也應該跟隨我們的腳步來研究如何應對這類詐騙。

🔸延伸閱讀:

從移花接木的 Deepfake 影音,看機器學習與網路攻擊

什麼是 Deepfake(深偽技術)? A 片女主角也可以造假!

篡改過的影片也可能被敵對國家或勒索罪犯利用

對那些能夠掌握有效深偽技術的人來說,能夠向對政府最高層級散播虛假訊息可以帶來無限的想像。也許更該擔心的是,篡改過的影片也可能被敵對國家或想勒索的網路犯罪分子用來破壞選民對候選人的信心。

這還不是全部。正如我們在2018年所說明的,相同技術可以用來進行變臉詐騙攻擊或稱為商務電子郵件入侵 (Business Email Compromise,簡稱 BEC),欺騙財務部門向第三方進行大量匯款。

試想一下,一位執行長透過Zoom來下達指示。這足以說服許多員工。實際上,已經利用Deepfake語音這樣做過了,在2019年就出現過英國高階主管這樣被騙匯出數十萬美元。我們的2020年預測其中之一就是深偽技術(Deepfake)將成為企業詐騙的下一個新領域。

延伸閱讀:網路釣魚進化成AI 語音釣魚,偽裝老闆聲音騙走770 萬台幣!

接下來會發生什麼?

出於金錢動機的勒索和社交工程以及目的在破壞民主穩定的影響行動只是個開端。一位專家最近聲稱,隨著AI技術變得更加先進和普及,在十年內智慧型手機就有足夠能力去製作出有高度說服力的深偽影像。那麼,我們能做些什麼?

從企業的角度來看,資安團隊需要做好準備。這意味著要留意像我們這樣的警告,了解該技術如何被運用在惡意用途。我們最近與聯合國和歐洲刑警組織合作發表了一篇關於AI運用和濫用的論文,這是個很好的出發點。

趨勢科技也進一步展望未來,預測AI技術和深偽技術(Deepfake)如何在幾年內成為網路軍備競賽的一環,所以請注意在今年RSA大會上發表的「Project 2030」。現在,我們需要更好地訓練員工識別假貨,並且用工具來做到這一點。

對抗惡意AI技術會是個漫長的旅程,但經由採取措施來更好地了解這類威脅,可以讓我們取得戰術上的優勢。俗話說得好,未雨綢繆,有備無患。

@原文出處:Deepfakes Are Getting Closer to Reality 作者:Rik Ferguson

[延伸閱讀:英國女王Deepfake搞笑版耶誕文告 幾可亂真引兩極論戰]