什麼是深偽影片?

深偽影片是一種逼真到讓人不容易起疑的影片,這類影片人類肉眼越來越難分辨它們是 AI 所生成的,對資料安全帶來了極大的風險。

深偽技術是利用人工智慧 (AI) 與機器學習 (Machine Learning, ML) 合成的新媒體形式。透過「換臉」、控制嘴唇動作、或植入假造的音源檔等手段,它能產生模仿人們講話或動作的超逼真影片或音訊 ,使其看起來就像是當事人真的說過或做過這些事情一樣。

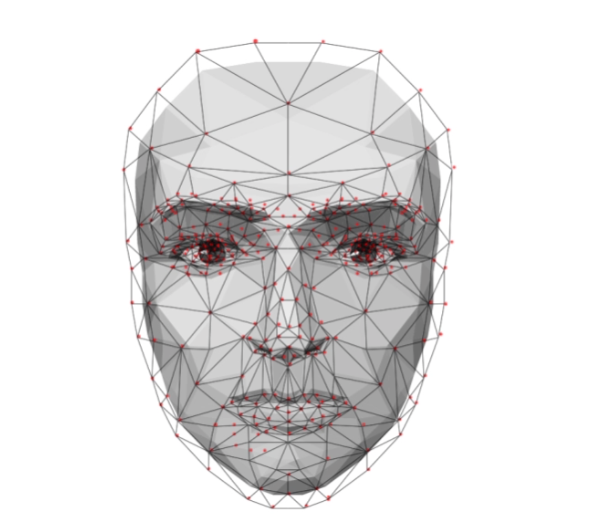

要製作深偽影片,通常需要先對原始內容進行深度的分析。一些必要的細節,如臉部特徵與動作、尺寸比例、膚色、髮色與眼睛顏色,以及肢體語言,都盡可能準確地輸入 AI 模型當中,以生成盡可能準確的擬真影像。同樣的原則也適用於影片的背景,如果目標對象出現的場景是知名的地點,那麼駭客就會利用一些原始影像和影片來盡可能準確地加以呈現。

最初,這項技術被用於製作色情、政治宣傳或嘲諷影片,且網路上流傳著上萬個深偽造假內容。隨著「換臉」軟體的普及,深度偽造內容也愈來愈多,甚至被廣泛用於犯罪。

深度偽造 (Deepfake)技術能產生模仿人們講話或動作的超逼真影片或音訊,使其看起來就像是當事人真的說過或做過這些事情一樣。現在甚至出現「換臉」軟體,也讓深度偽造 (deepfake)惡搞影片愈來愈多,甚至被用來犯罪。

與生成深偽影片一樣,駭客也能用網路上找到的材料來訓練 AI 生成聲音。其參考來源通常是被模仿對象的語音郵件訊息、電話內容、參加 Podcast 與新聞訪談的錄音,以及真實影片當中的聲音。

生成的聲音有時聽起來非常逼真,跟原始材料中的聲音非常相似,讓人難辨真假。駭客使用的生成式 AI 工具會分析聲音的一些關鍵細節,包括:口氣、音調、說話特徵、口齒清晰度,以及原始對象講話的聲音情緒。

機器學習(Machine learning,ML) 一般個人和企業機構 構成嚴重風險。

⭕️ 重點預覽

繼續閱讀

⟫ 看答案

⟫ 看答案